你是从什么时候开始用 DeepSeek 的?春节前, DS 响应非常丝滑流畅。随着春节期间 DS 火爆全球用户暴增后,就开始频繁出现“服务器繁忙”。

后来国内很多大厂和平台也接入了 DeepSeek-R1 模型。很多平台,超过免费额度后,基本都是就要氪金付费了。

有一天晚上八九点,我分时段反复试了多次尝试某国家队平台,但每次都显示:“资源正在申请中,请您耐心等待”。后来第二天凌晨 2:30 左右才收到资源通过的短信。( ̄. ̄)

问题来了:有没有免费又简单的方法使用 DeepSeek 呢?

答案是肯定的,那就是本地部署模型。

本地部署的好处和缺点

- 好处:从根本上避免因服务器过载导致的访问问题。数据无需上传云端,也不用担心泄露风险。

- 缺点:对个人硬件有要求,有一定技术门槛和维护成本。

好处和缺点不止上面这几点,本文不展开细讲。你直接问 DS 也能得到答案。

DeepSeek-R1 各版本的特点及适用场景

DS-R1 有多个版本,它们的特点和适用场景请直接看下方表格:

本文将主要关注轻量级模型,这也是适用于我们大多数个人用户的部署方式。

如何本地部署?

部署方法其实有很多,本文介绍基于 Ollama 实现本地部署。

Ollama 是一个支持在本地运行大型语言模型的工具,能够帮助用户快速部署和管理模型。

1、安装 Ollama

从 Ollama 官网下载:https://ollama.com/download ,选择对应的版本下载并安装。

安装成功后桌面就有 Ollama 的羊驼标志。

2、部署 DeepSeek R1 模型

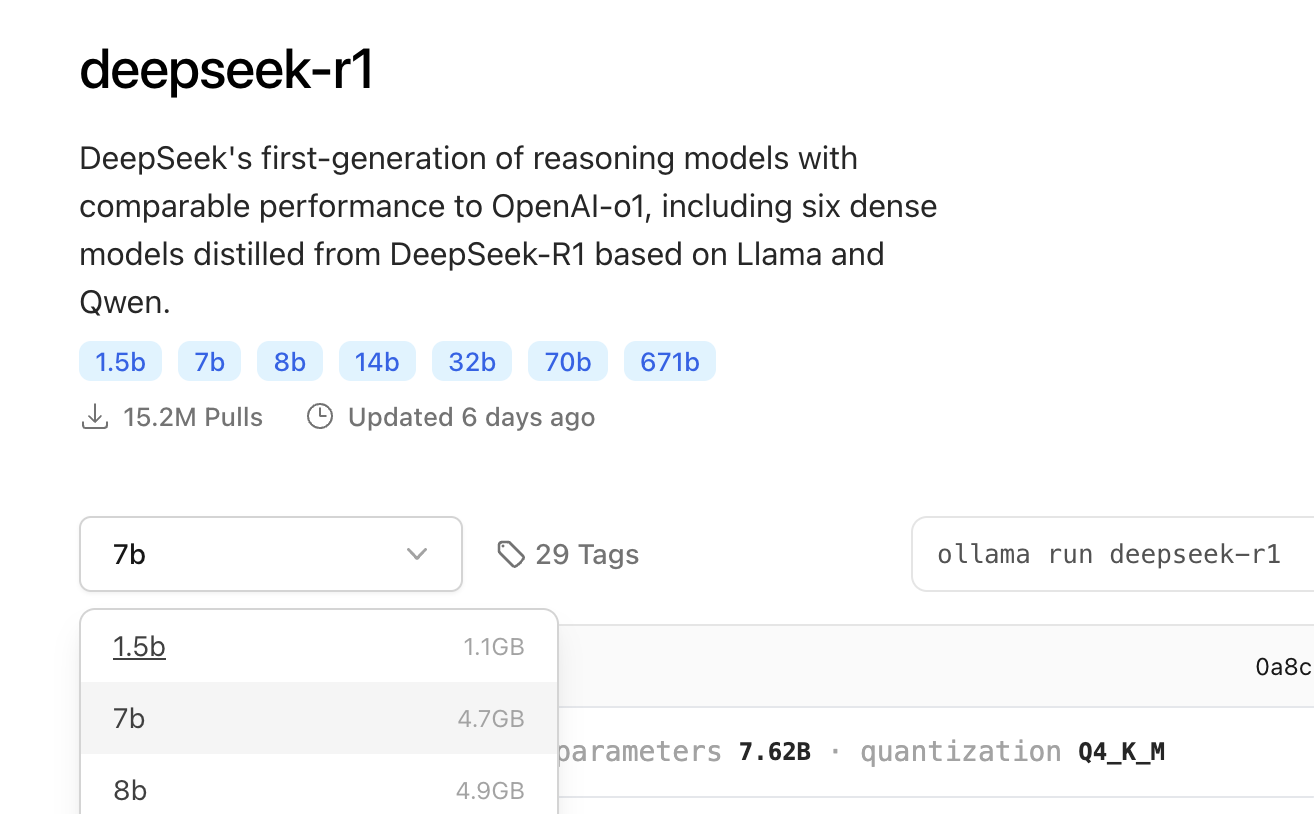

Ollama 官网支持多种 DeepSeek-R1 版本,可以在 https://ollama.com/search

看到 1.5B 到 671B 共 7 个不同规模的共 29 个不同版本,其中包括一些基于开源模型 Llama 和 Qwen 进行微调、蒸馏或量化处理后得到的模型。

DeepSeek-R1 1.5B 版本对硬件配置要求最低,本文就以它为例。

双击羊驼启动 Ollama,然后打开终端工具,复制粘贴运行下方命令:

ollama run deepseek-r1:1.5b

成功后会显示 success,我尝试问了它是谁。我再问了它“如何学习编程”,也是给了八点建议。

如果你是技术流用户,到这一步就已经算是成功部署 DeepSeek R1 模型啦。

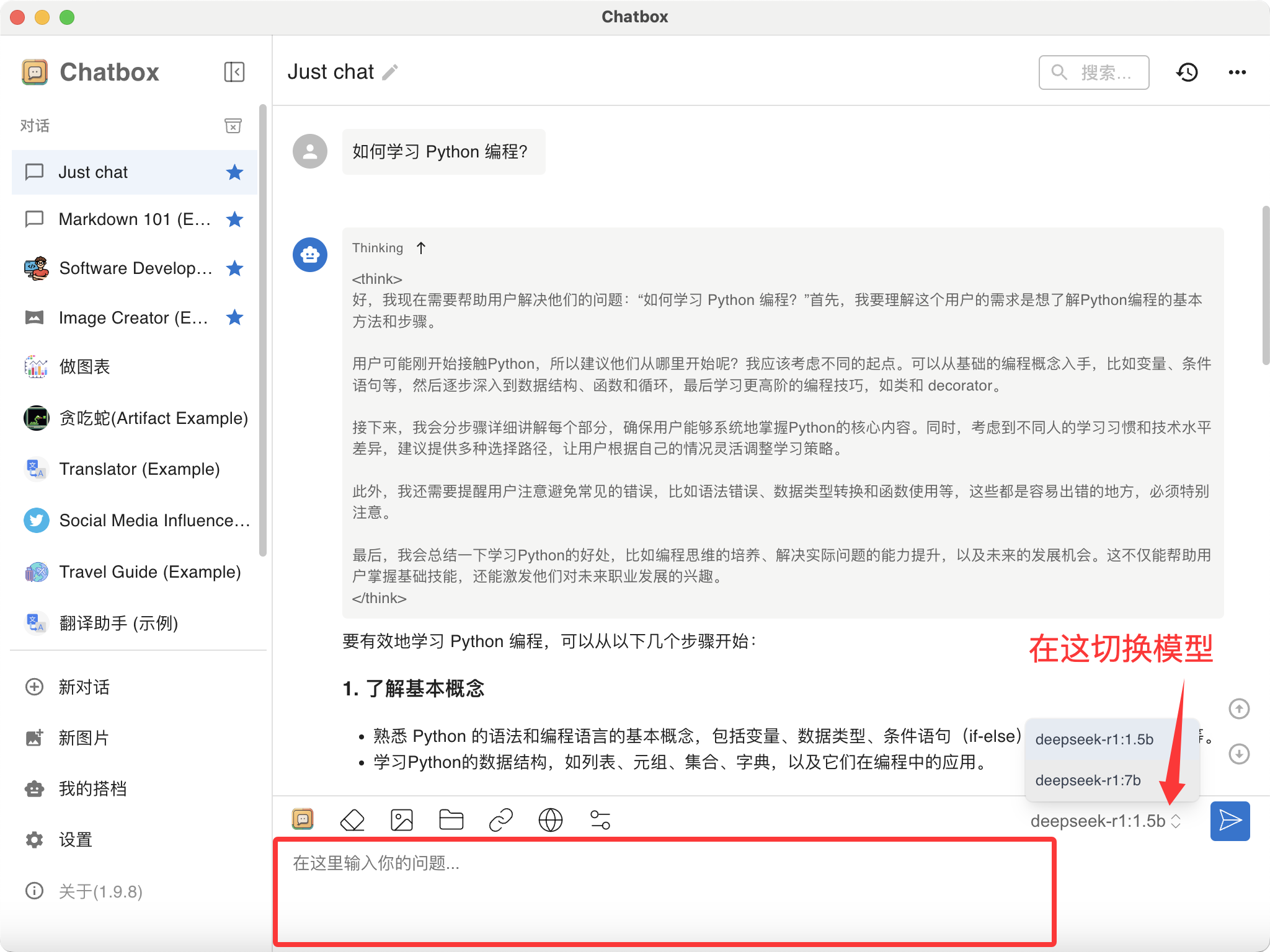

但对普通用户来说,命令行不友好,还需要配置一个好用的前端,本文选用 Chatbox。

3、安装 Chatbox

Chatbox 是一款开源的 AI 客户端,旨在为用户提供便捷的本地化 AI 对话体验。它支持多种大型语言模型(LLMs),包括 OpenAI 的 GPT 系列、本地部署的模型(如 LLaMA、DeepSeek 等),并提供了一个直观的图形界面,方便用户与 AI 模型交互。

打开 Chatbox 官网(https://chatboxai.app/zh )下载安装。

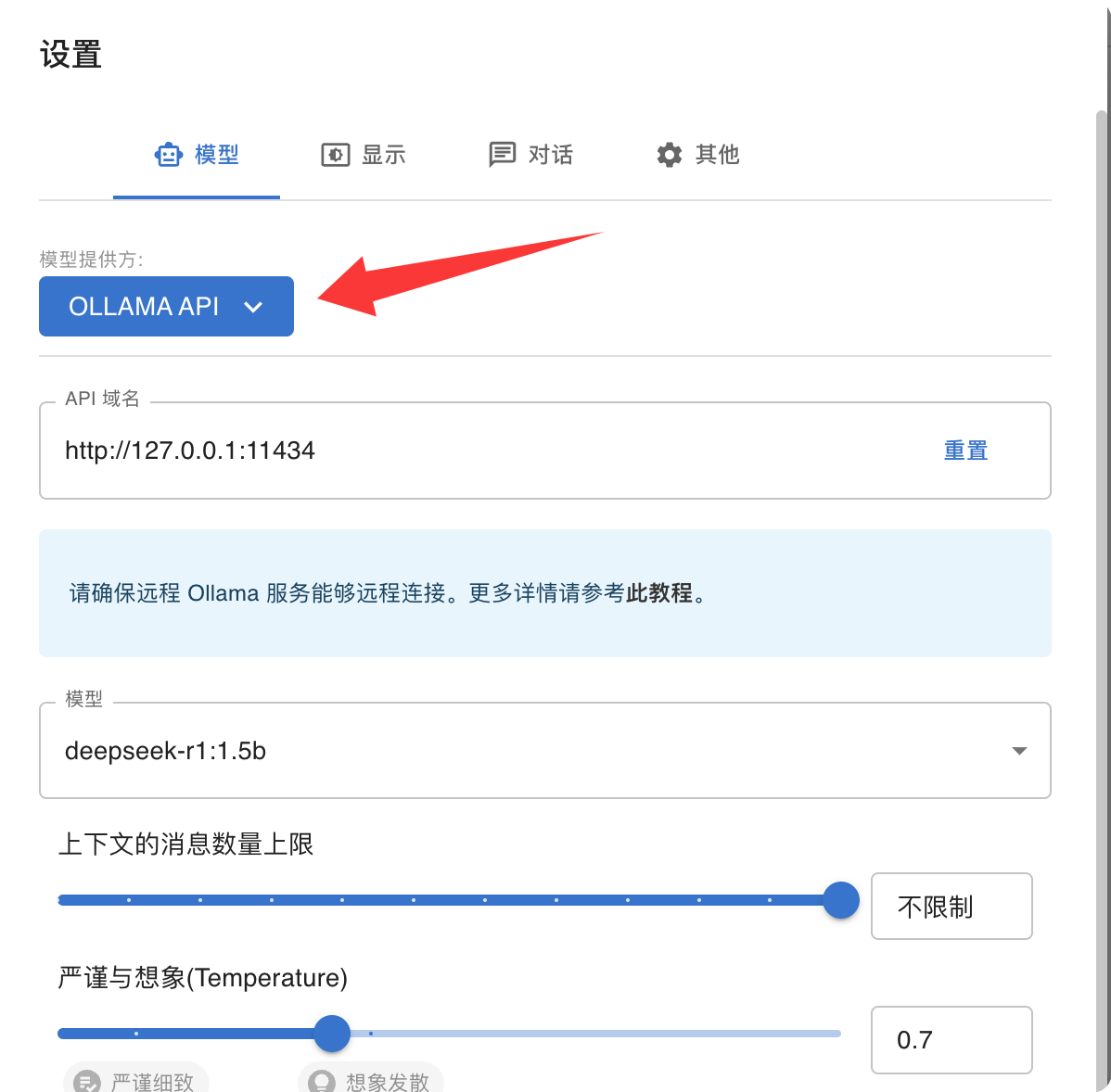

安装后打开客户端,从左下角点击“设置”,

- “模型提供方”选择

Ollama API,“API 域名”保持默认配置,无需更改, - 它可以自动识别已通过 Ollama 安装的模型

- “上下文消息数量的上限” 默认是 20,调整到“不限制”

保存设置后,我们就可以在聊天窗口中和 DS 聊天了。

如果你有多个本地模型,还可以随时切换。

到这里为止,我们就顺利地在本地部署 DeepSeek。✿✿ヽ(°▽°)ノ✿

本文所用到的 AI 工具,MaxAIBox 均已收录:

后记:

我在两台电脑上跑了模型。第一台是 8G 内存的 M1 版 Mac,我安装了 1.5B 和 7B 两个模型。由于配置较低,当与 7B 模型聊天时,电脑几乎“假死”,完全动不了了。 😅

另外一台是 16G 内存 M4 芯片的 Mac min 安装了 14B,跑起来还是顺畅的。

ds-r1 1.5B 和 14B 的对比:

我在两台设备上分别问了一些相同的问题。

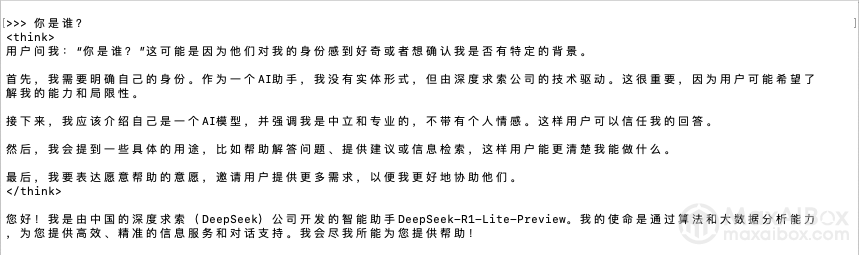

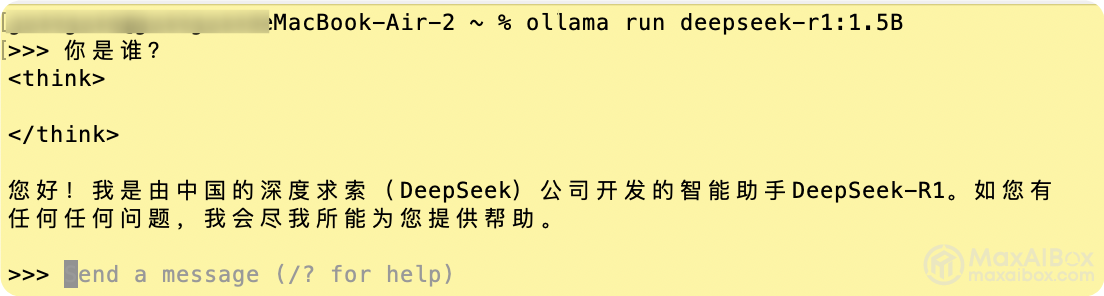

“你是谁?”

DS-R1:14B,命令行

DS-R1:1.5B,命令行

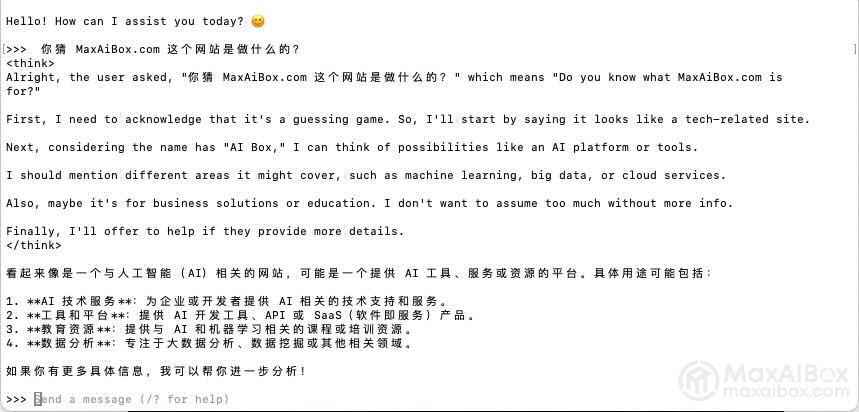

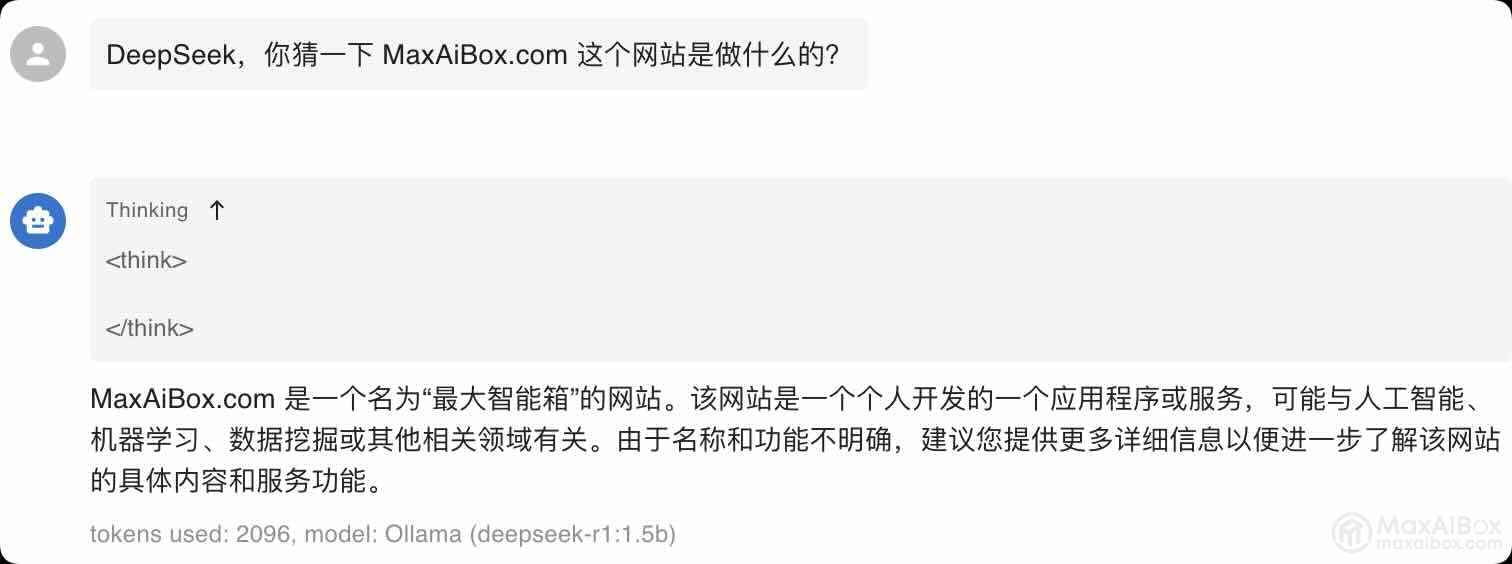

“你猜一下 MaxAiBox.com 这个网站是做什么的?”

DS-R1:14B,命令行

ds-r1:1.5,Chatbox

因为 MaxAIBox 这个网站不在 DS 训练语料库,所以 DS 只能从从名字着手开始猜了。从两个模型对话来看,1.5B 和 14B 的模型差别非常明显。电脑配置够的情况下,尽量使用更大的模型。此外,在命令行和大模型聊天,体验不好,大家还是安装前端客户端工具吧~

© 版权声明

文章版权归作者所有,未经允许请勿转载。